Inhaltsverzeichnis

Deep Learning ist eine Methode zur Informationsverarbeitung, bei der künstliche neuronale Netze mit vielen Schichten zum Einsatz kommen. Die Bezeichnung „deep“ leitet sich aus diesen Schichten ab. Diese Methode wird vor allem dann verwendet, wenn klassische Programmieransätze an ihre Grenzen stoßen, weil keine festen Regeln oder Algorithmen zur Lösung eines Problems bekannt sind. In diesem Beitrag erfahren Sie alles Wichtige rund um das Thema Deep Learning.

Deep Learning „kurz erklärt“

Deep Learning ist ein Teilbereich des maschinellen Lernens, bei dem künstliche neuronale Netzwerke mit vielen Schichten eingesetzt werden, um Muster in großen Datenmengen zu erkennen und zu verarbeiten.

Es imitiert die Funktionsweise des menschlichen Gehirns, indem es Eingabedaten wie Bilder, Texte und Ton Schicht für Schicht verarbeitet. Jede Schicht lernt dabei zunehmend abstraktere Merkmale. Als Synonym für Deep Learning kann auch „tiefes Lernen“ verwendet werden.

Definition: Deep Learning

Unter Deep Learning wird ein Teilgebiet des maschinellen Lernens und damit der Künstlichen Intelligenz (KI) verstanden, bei dem Computer lernen, selbstständig aus großen Datenmengen Muster und Zusammenhänge zu erkennen. Dafür werden künstliche neuronale Netzwerke, die aus vielen hintereinandergeschalteten Schichten bestehen, verwendet.

Diese Netzwerke sind in der Lage, große Mengen an Daten zu verarbeiten und dabei automatisch abstrakte Merkmale und Zusammenhänge zu erkennen, ohne dass diese vorher manuell definiert werden müssen. Als Synonym für Deep Learning kann auch „tiefes Lernen“ verwendet werden.

Es hat sich herausgestellt, dass sich viele komplexe Probleme mit solchen Netzwerken lösen lassen. Deep Learning kommt vor allem dann zum Einsatz, wenn herkömmliche Programmiermethoden an ihre Grenzen stoßen, etwa bei der Spracherkennung, der Bildanalyse oder der Vorhersage komplexer Muster. Durch die Schicht-für-Schicht-Verarbeitung kann das System abstrakte Informationen Schritt für Schritt ableiten und so auch hochkomplexe Probleme lösen.

Als Definition von Deep Learning kann also gelten, dass es sich um Informationsverarbeitung durch ein neuronales Netz handelt, in dem Eingabe und Ausgabe durch mehrere Schichten von Neuronen voneinander getrennt sind. Tiefes Lernen hilft Computern also dabei, Dinge zu „verstehen“ und große Mengen an Daten automatisch zu digitalisieren und auszuwerten, ohne dass ihnen jeder Schritt vorher genau erklärt werden muss.

Funktionsweise

Deep Learning funktioniert ähnlich wie das menschliche Gehirn, da eingehende Daten ähnlich wie Sinneseindrücke Schicht für Schicht verarbeitet werden. Zuerst erkennt das tiefe neuronale Netzwerk einfache Merkmale, anschließend komplexere Zusammenhänge. Am Ende kann es auf Basis der gelernten Muster in verschiedenen Anwendungen fundierte Entscheidungen oder Prognosen treffen, etwa zur Bilderkennung oder zur Vorhersage zukünftiger Ereignisse.

Entwicklung und Entstehung

Ursprünglich war Informationsverarbeitung stark regel- und symbolbasiert: Computer führten klar definierte Anweisungen aus, etwa Rechenaufgaben oder Textverarbeitung. Doch viele Aufgaben, die Menschen intuitiv lösen, wie Gesichtserkennung oder Sprachverständnis, ließen sich nicht in einfache Regeln übersetzen.

Schon in den 1960er-Jahren begannen Forscher daher, künstliche neuronale Netze zu entwickeln, die solche Aufgaben selbstständig lernen konnten. Frühbeispiele wie das GMDH-Netzwerk von Oleksij Iwachnenko oder Karl Steinbuchs Lernmatrix legten die Grundlage.

In den 1980er-Jahren wurden die Netzwerke komplexer, etwa mit dem Neocognitron von Kunihiko Fukushima, einem Vorläufer moderner Bilderkennungsnetze. Einen praktischen Durchbruch erreichte Yann LeCun 1989 mit einem System zur Erkennung handgeschriebener Postleitzahlen.

Ab den 2000er-Jahren ermöglichte die steigende Rechenleistung das Training tiefer Netzwerke – sogenannte Deep-Learning-Systeme. Besonders erfolgreich war die Arbeit von Jürgen Schmidhubers Team, das mit LSTM-Netzen internationale Wettbewerbe gewann.

Der Begriff „Deep Learning“ wurde zwar bereits 1986 von Rina Dechter im Zusammenhang mit Suchalgorithmen verwendet, setzte sich aber erst ab 2000 im Kontext tiefer neuronaler Netze durch.

Große Aufmerksamkeit erhielt die Methode ab 2016 durch spektakuläre Erfolge wie den Sieg von AlphaGo oder die Vorhersage von Proteinfaltungen durch AlphaFold. Für ihre bahnbrechenden Arbeiten wurden Forscher wie LeCun, Hinton und Bengio mit dem Turing Award und später sogar mit dem Physik-Nobelpreis ausgezeichnet.

Zusammenhang von Deep Learning und künstlicher neuronalen Netze

Deep Learning basiert auf künstlichen neuronalen Netzen (KNN). Dies ist eine Technik, die sich am Aufbau des menschlichen Gehirns orientiert. Diese Netze bestehen aus vielen miteinander verbundenen Einheiten, sogenannten Neuronen, die Informationen verarbeiten und weiterleiten. Ein künstliches Neuron ist für sich betrachtet relativ einfach aufgebaut: Es empfängt Eingangssignale, gewichtet sie und gibt ein Ausgangssignal weiter.

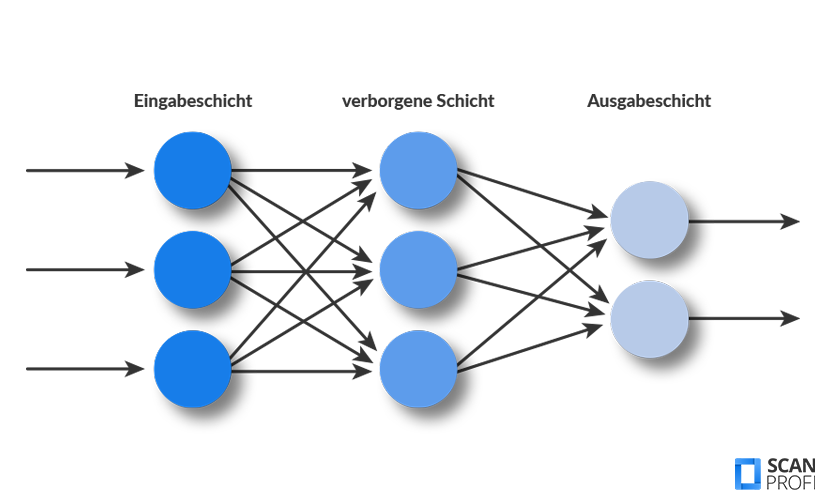

Ein neuronales Netzwerk setzt sich in der Regel aus drei Hauptkomponenten zusammen: einer Eingangsschicht, dem Input Layer, einer oder mehreren versteckten Schichten, den Hidden Layers, und einer Ausgangsschicht, dem Output Layer. Die Tiefe eines Netzwerks, also die Anzahl an Hidden Layers, bestimmt, ob es sich um klassisches maschinelles Lernen oder um tiefes Lernen handelt. Sobald ein Modell mehr als eine versteckte, also mittlere Schicht besitzt, spricht man in der Regel von Deep Learning.

In den versteckten Schichten befinden sich die sogenannten Gewichte. Diese steuern, wie stark ein Eingangssignal das Ausgangssignal beeinflusst. Die Aktivierung dieser Neuronen erfolgt über mathematische Aktivierungsfunktionen, die die Eingangssignale transformieren. Beim Training des Netzwerks werden diese Gewichte so angepasst, dass das Modell für Eingabedaten die gewünschte Ausgabe erzeugt, beispielsweise die korrekte Klassifikation eines Bildes.

Ein Deep-Learning-Modell wird anhand von sehr vielen Beispielen trainiert, sogenannten Eingabe-Ausgabe-Paaren. Ziel ist es, dass das Netz daraus Muster erkennt und generalisiert, sodass es auch neue, unbekannte Aufgaben lösen kann. Durch die Vielzahl an Neuronen und Parametern ist der Lernprozess sehr leistungsfähig, aber auch schwer zu durchschauen, weshalb Deep-Learning-Modelle oft als „Black Box“ gelten.

Künstliche neuronale Netze sind somit das zentrale Element im tiefen Lernen. Je nach Komplexität kann ein solches Netzwerk aus wenigen oder aus hunderten Schichten bestehen – mit entsprechend hoher Rechenleistung und Datenmenge.

Modelle

Es gibt verschiedene Arten von neuronalen Netzen, die je nach Art der Daten oder Aufgabe zum Einsatz kommen. Im Folgenden findest du die wichtigsten Modelltypen und wofür sie typischerweise verwendet werden.

CNNs steht für Konvolutionale neuronale Netzwerke.

Einsatzgebiete sind: Bilderkennung, Videos, Objekterkennung.

Zu den Stärken gehören:

- Besonders leistungsfähig bei visuellen Daten

- Erkennen Kanten, Muster und Formen automatisch

- Verarbeiten hochauflösende Bilddaten effizient

Beispiele: Gesichtserkennung, medizinische Bildanalyse, Verkehrszeichenerkennung

Die Abkürzung RNNs bezeichnet Rekurrente neuronale Netze.

Einsatzgebiete sind: Sprache, Texte, Zeitreihen.

Zu den Stärken zählen:

- Verarbeiten Daten mit zeitlichem Verlauf (z. B. Sprache, Finanzdaten)

- Nutzen frühere Eingaben für aktuelle Vorhersagen („Gedächtnis“)

Es gibt jedoch auch Schwächen:

- Probleme mit langen Abhängigkeiten („verlorenes Gedächtnis“)

- Langsames Training, instabile Gradienten

Eine Erweiterung ist:

- LSTM (Long Short-Term Memory): Bessere Verarbeitung langfristiger Zusammenhänge

Beispiele: Sprachübersetzung, Sprachsteuerung, Börsenprognosen

GANs bedeutet Generative Adversariale Netzwerke.

Zu den Einsatzgebieten zählen: Bild- und Videoerzeugung.

Stärken sind:

- Erzeugen täuschend echte neue Inhalte (z. B. Gesichter, Kunstwerke)

- Bestehen aus zwei Netzen (Generator + Prüfer), die sich gegenseitig verbessern

Beispiele: Deepfakes, KI-generierte Kunst, synthetische Trainingsdaten

VAE ist die Abkürzung für Variational Autoencoder.

Einsatzgebiete sind: Datenkomprimierung & Generierung.

Zu den Stärken gehören:

- Reduzieren komplexe Daten auf das Wesentliche

- Können beschädigte Daten rekonstruieren

- VAEs generieren neue, ähnliche Daten (z. B. Bilder oder Texte)

Beispiele: Anomalieerkennung, Bildreparatur, Textsynthese

Einsatzgebiete von Transformer-Modellen sind: Sprache, Texte, Dialogsysteme.

Zu den Stärken zählen:

- Verarbeiten ganze Texte parallel statt Wort für Wort

- Verstehen Zusammenhänge über lange Textabschnitte

- Sehr leistungsfähig in der natürlichen Sprachverarbeitung (NLP)

Beispiele: ChatGPT, Übersetzungsdienste, Textzusammenfassungen

Diffusionsmodelle werden für hochqualitative Bildgenerierung eingesetzt.

Die Stärken sind:

- Sehr realistische Ergebnisse bei Bildern

- Robusteres Training als bei GANs

- Weniger anfällig für Modus-Kollaps

Beispiele: Bildgeneratoren wie Stable Diffusion

Je nach Aufgabe kommen unterschiedliche Netzwerktypen zum Einsatz. Während CNNs für Bilddaten optimiert sind, eignen sich RNNs und Transformer für Sprache und Text. Autoencoder und GANs erzeugen neue Inhalte, und Diffusionsmodelle setzen neue Standards bei Bildqualität.

So zeigt sich: Deep Learning ist nicht ein Modell, sondern eine Vielzahl spezialisierter Modelltypen.

Deep Learning vs. Machine Learning

Deep Learning ist ein Teilbereich von maschinellem Lernen. Machine Learning umfasst also auch Lernmethoden, die nicht zum tiefen Lernen gehören. Die folgende Tabelle zeigt die Unterschiede zwischen Deep Learning und Machine Learning.

Aspekt

Deep Learning

Machine Learning

Genetische Algorithmen

Nein, nutzt hauptsächlich neuronale Netzwerke.

Ja, evolutionäres Vorgehen zur Optimierung.

Datenstruktur

Mischung aus strukturierten & un-

strukturierten Daten.Nur strukturierte Daten.

Datenmenge

Es sind große Datenmengen erforderlich.

Es ist eine kleine bis mittlere Menge an Daten notwendig.

Feature Extraction

Erfolgt automatisch durch das Netzwerk.

Die Merkmale müssen manuell durch Fachwissen ausgewählt werden.

Hardware

Es sind hohe Rechenleistungen (GPUs) erforderlich.

Oft reicht Standardhardware aus.

Trainingsdauer

Braucht extrem lange, meist Stunden bis Wochen.

Die Dauer ist kurz bis moderat.

Interpretierbarkeit

Die Algorithmen sind schwer bis gar nicht interpretierbar.

Man kann die Algorithmen teilweise gut nachvollziehen.

Einsatzgebiete

sowie bei komplexen Mustererkennungen.In klassischen Datenanalysen, beispielsweise bei Tabellen.

Verschiedene Frameworks

Heutzutage gibt es verschiedene Deep-Learning-Frameworks, die fast alle in der Programmiersprache Python entwickelt wurden, da sie leicht verständlich sind und viele nützliche Bibliotheken für Datenverarbeitung und Künstliche Intelligenz bieten. Zu den bekanntesten Frameworks zählen Keras, TensorFlow und PyTorch.

Ein Überblick über die wichtigsten Merkmale von Keras:

- Leicht verständliches Framework zur schnellen Entwicklung neuronaler Netze.

- In Python geschrieben.

- Kann eigenständig oder in Kombination mit TensorFlow verwendet werden.

- Besonders geeignet für dynamische, sich verändernde Projekte.

- Open Source, mit aktiver Community.

- Ideal für Einsteiger und zur schnellen Prototypenentwicklung.

Die relevantesten Merkmale von TensorFlow im Überblick:

- Sehr weit verbreitetes Open-Source-Framework von Google.

- Entwickelt für maschinelles Lernen und KI-Anwendungen (z. B. Bilderkennung, Sprachverarbeitung).

- Hauptsprachen: Python & C++.

- Es wird unter anderem bei Google Search, Gmail und Google Fotos eingesetzt.

Ein Überblick über die wichtigsten Merkmale von PyTorch:

- Open-Source-Framework von Facebooks KI-Forschungsteam.

- Nutzt Python, C und CUDA.

- Flexibel, integrierbar mit anderen Python-Bibliotheken.

- Unterstützt auch mobile Plattformen (Android, iOS).

- Wird z. B. von OpenAI eingesetzt.

Anwendungsbeispiele

Tiefes Lernen wird überall dort eingesetzt, wo klassische Algorithmen an ihre Grenzen stoßen, etwa weil kein klarer Lösungsweg bekannt ist oder weil die Datenmenge zu groß und komplex ist. Man unterscheidet dabei zwischen Fällen, bei denen ein Algorithmus zwar möglich, aber nicht bekannt ist, und solchen, in denen ein regelbasiertes Vorgehen praktisch nicht umsetzbar ist.

Probleme mit unbekanntem Algorithmus:

- Proteinfaltung

- Automatische Textübersetzung

Probleme ohne klar definierbaren Lösungsweg:

- Bilderkennung

- Spracherkennung und -verstehen

Im Folgenden wird die Anwendung von tiefem Lernen in einzelnen Branchen erläutert.

Marketing

Im Marketing ermöglicht tiefes Lernen eine deutlich präzisere Personalisierung von Kampagnen und Angeboten. Anstatt große Zielgruppen grob zu klassifizieren, analysieren neuronale Netze das Verhalten einzelner Kunden in Echtzeit, etwa ihr Klickverhalten, die Kaufhistorie oder die Interaktionen auf Social Media.

Auf dieser Basis lassen sich individuelle Empfehlungen ausspielen, Kundenbedürfnisse besser verstehen und verändertes Kaufverhalten frühzeitig erkennen.

Medizin

Im medizinischen Bereich hilft Deep Learning, große Mengen an Patientendaten effizient auszuwerten. Algorithmen analysieren Laborwerte, Bilddaten oder ärztliche Befunde und geben Hinweise auf mögliche Diagnosen oder empfehlen passende Therapien.

Zudem lassen sich durch tiefes Lernen Risikopatienten frühzeitig identifizieren, Medikationspläne optimieren und die Dokumentation automatisieren. Damit trägt die Technologie zur frühzeitigen Erkennung, besseren Versorgung und Entlastung des medizinischen Personals bei.

Mobilität

Im Bereich der Mobilität sorgt tiefes Lernen dafür, dass Fahrzeuge ihre Umgebung präzise wahrnehmen und darauf reagieren können. Kameras, Sensoren und Radar liefern riesige Datenmengen, die von neuronalen Netzen in Echtzeit ausgewertet werden. Das System erkennt Verkehrszeichen, Fußgänger, andere Fahrzeuge oder Fahrbahnmarkierungen und trifft entsprechend Entscheidungen.

Zusammenfassung

Deep Learning ist ein faszinierendes Forschungsgebiet, das sein Potenzial in den vergangenen zwei Jahrzehnten auf eindrucksvolle Weise unter Beweis gestellt hat. Die Methode liefert bereits heute ausgezeichnete Ergebnisse in etlichen Fachgebieten. Weiterhin bietet tiefes Lernen auch einen Zugang zum besseren Verständnis der menschlichen Denkprozesse.

Es ist auch damit zu rechnen, dass Deep Learning nicht nur in diesen, sondern auch in zahlreichen anderen Fachgebieten zum Einsatz kommen wird. Gerade wenn Sie in Ihrem Bereich von tiefem Lernen noch nichts gehört haben, sollten Sie diesen Typ der Informationsverarbeitung im Auge behalten. Dann können Sie zu den Ersten gehören, die tiefes Lernen in Ihrem Gebiet einsetzen, und als Pionier die ersten und als solche oft aufsehenerregendsten Resultate erzielen.

Häufig gestellte Fragen

Viele Probleme der Informationsverarbeitung ließen sich lange Zeit nicht mit klassischen Algorithmen lösen. Menschen dagegen bewältigen solche Aufgaben meist mühelos. Naheliegend war daher die Idee, den Aufbau des menschlichen Gehirns als Vorbild für künstliche Systeme zu nutzen. Deep Learning greift dieses Prinzip auf: In künstlichen neuronalen Netzen werden Konzepte durch Neuronen und deren Verbindungen abgebildet, ähnlich wie im biologischen Nervensystem.

Deep Learning ist ein Teilbereich von maschinellem Lernen, bei dem künstliche neuronale Netze mit vielen Schichten eingesetzt werden, um große Datenmengen zu analysieren und daraus Muster oder Zusammenhänge zu erkennen, ähnlich wie das menschliche Gehirn. So können komplexe Aufgaben wie Spracherkennung, Bilderkennung oder präzise Vorhersagen automatisiert gelöst werden.

Deep Learning wird heute z. B. für Gesichts- und Spracherkennung, medizinische Diagnosen, autonomes Fahren und Textgenerierung (z. B. ChatGPT) eingesetzt. In vielen Bereichen ist es präziser und schneller als der Mensch, etwa bei der Analyse von Bildern oder beim Übersetzen. Ein Meilenstein war 2016 der Sieg von AlphaGo über den Weltmeister im Spiel Go.

Die Realisierung erfolgt derzeit praktisch ausschließlich in Software. Für eine Hardwarelösung wäre es notwendig, die Parameter des neuronalen Netzwerks im Gerät selbst zu verändern, was mit der derzeit verfügbaren Elektronik kaum möglich ist.